File robots.txt giúp bạn kiểm soát thu thập dữ liệu website. Tạo file robots.txt chuẩn SEO nhanh chóng, dễ dàng với công cụ trực quan của KiraApp. Bứt phá thứ hạng!

*.Disallow: /.

Bạn có biết rằng một file nhỏ bé mang tên file robots.txt lại có sức mạnh to lớn trong việc điều hướng các công cụ tìm kiếm như Google? Nó giống như một bản đồ chỉ dẫn, giúp các bot của Google biết khu vực nào trên website của bạn nên ghé thăm và khu vực nào nên tránh xa.

Nếu không có file robots.txt, website của bạn có thể bị thu thập dữ liệu không hiệu quả, ảnh hưởng đến thứ hạng SEO và thậm chí là làm lộ những thông tin không mong muốn. Vậy nên, việc hiểu rõ và sử dụng file robots.txt một cách chính xác là vô cùng quan trọng.

Trong bài viết này, chúng ta sẽ cùng nhau khám phá mọi ngóc ngách của robots.txt, từ định nghĩa cơ bản đến cách tạo và tối ưu nó để đạt hiệu quả SEO tốt nhất. Đặc biệt, tôi sẽ giới thiệu đến bạn công cụ tạo robots.txt online của KiraApp, một giải pháp nhanh chóng, dễ dàng và chuẩn SEO cho mọi webmaster.

File robots.txt đóng vai trò then chốt trong việc tối ưu hóa công cụ tìm kiếm (SEO) cho website của bạn. Hãy tưởng tượng nó như một người gác cổng, quyết định những vị khách (bot tìm kiếm) nào được phép vào và những khu vực nào trong ngôi nhà (website) của bạn mà họ không nên bén mảng tới.

Dưới đây là những lợi ích chính mà file robots.txt mang lại:

Một file robots.txt được cấu hình đúng cách sẽ giúp website của bạn hoạt động trơn tru hơn, thân thiện hơn với các công cụ tìm kiếm và đạt được thứ hạng cao hơn trên kết quả tìm kiếm. Nếu bạn muốn tìm hiểu sâu hơn về cách tối ưu SEO cho website WordPress của mình, hãy tham khảo bài viết SEO WordPress với AI bí quyết bứt phá traffic cực mạnh.

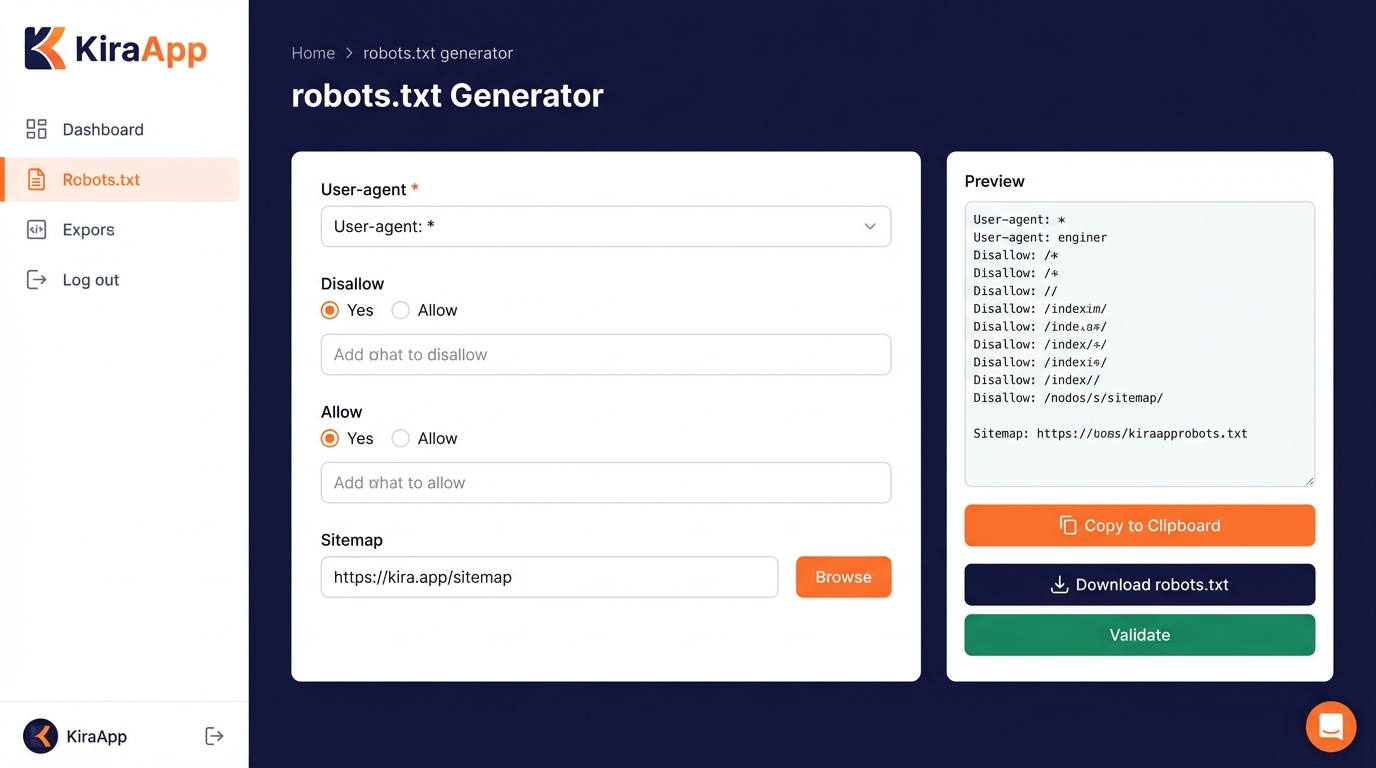

Tạo một file robots.txt không khó, nhưng để tạo ra một file chuẩn SEO, hiệu quả thì không phải ai cũng làm được. Đó là lý do tại sao KiraApp đã phát triển một công cụ tạo file robots.txt online, giúp bạn đơn giản hóa quy trình này và đảm bảo có được một file robots.txt tối ưu nhất.

Dưới đây là hướng dẫn chi tiết cách sử dụng công cụ của KiraApp:

Đầu tiên, bạn hãy truy cập vào công cụ tạo file robots.txt của KiraApp theo đường dẫn sau: Công cụ tạo file robots.txt.

Tại giao diện của công cụ, bạn sẽ thấy các tùy chọn cấu hình cơ bản sau:

Hãy điền đầy đủ thông tin vào các trường này dựa trên nhu cầu của bạn.

Ngoài các tùy chọn cơ bản, bạn có thể thêm các quy tắc tùy chỉnh để kiểm soát thu thập dữ liệu một cách chi tiết hơn. Ví dụ:

Để thêm quy tắc, bạn chỉ cần nhấp vào nút “Thêm quy tắc” và điền thông tin vào các trường tương ứng.

Sau khi đã cấu hình xong, bạn có thể xem trước nội dung của file robots.txt bằng cách nhấp vào nút “Xem trước”. Nếu mọi thứ đã chính xác, hãy nhấp vào nút “Tải xuống” để tải file về máy tính của bạn.

Cuối cùng, bạn cần tải file robots.txt vừa tạo lên thư mục gốc của website. Bạn có thể sử dụng trình quản lý file của hosting hoặc phần mềm FTP để thực hiện việc này.

Vậy là xong! Bạn đã tạo và cấu hình thành công file robots.txt cho website của mình bằng công cụ của KiraApp. Thật đơn giản phải không nào?

Ngoài những ứng dụng cơ bản, file robots.txt còn có thể được sử dụng trong nhiều trường hợp nâng cao khác. Dưới đây là một vài ví dụ:

Không phải tất cả các bot đều tốt. Một số bot có thể gây hại cho website của bạn bằng cách spam, thu thập dữ liệu trái phép hoặc thậm chí là tấn công DDoS. Bạn có thể sử dụng file robots.txt để chặn các bot này bằng cách thêm quy tắc Disallow cho user-agent của chúng.

Nếu website của bạn có nhiều phiên bản ngôn ngữ (ví dụ: tiếng Anh, tiếng Việt, tiếng Pháp), bạn có thể sử dụng file robots.txt để hướng dẫn bot tìm kiếm thu thập dữ liệu phiên bản ngôn ngữ phù hợp với người dùng.

Các tham số URL (ví dụ: ?utm_source=facebook) có thể tạo ra các trang trùng lặp, gây ảnh hưởng đến SEO. Bạn có thể sử dụng file robots.txt để chặn bot thu thập dữ liệu các trang có chứa các tham số này.

Dưới đây là một ví dụ về file robots.txt nâng cao:

User-agent: *

Disallow: /wp-admin/

Disallow: /search/

Disallow: /*?utm_source=*

User-agent: Googlebot

Allow: /

Sitemap: https://example.com/sitemap.xmlTrong ví dụ này, chúng ta chặn tất cả các bot truy cập vào thư mục wp-admin, trang tìm kiếm và các trang có chứa tham số utm_source. Đồng thời, chúng ta cho phép Googlebot truy cập vào toàn bộ website và khai báo đường dẫn đến sitemap XML.

File robots.txt là gì? Tại sao website nào cũng cần?

Mặc dù file robots.txt rất hữu ích, nhưng nếu sử dụng không đúng cách, nó có thể gây ra những hậu quả nghiêm trọng cho website của bạn. Dưới đây là một số sai lầm phổ biến cần tránh:

Để tránh những sai lầm này, hãy luôn cẩn trọng và kiểm tra kỹ lưỡng trước khi áp dụng bất kỳ thay đổi nào cho file robots.txt của bạn.

File robots.txt là một công cụ mạnh mẽ, giúp bạn kiểm soát cách các công cụ tìm kiếm thu thập dữ liệu website. Bằng cách sử dụng nó một cách thông minh và hiệu quả, bạn có thể cải thiện thứ hạng SEO, tiết kiệm tài nguyên và bảo vệ nội dung riêng tư.

Nếu bạn đang tìm kiếm một giải pháp nhanh chóng, dễ dàng và chuẩn SEO để tạo file robots.txt, hãy thử ngay công cụ của KiraApp. Với giao diện trực quan, các tùy chọn cấu hình linh hoạt và khả năng tạo quy tắc tùy chỉnh, công cụ này sẽ giúp bạn tạo ra một file robots.txt hoàn hảo cho website của mình.

Đừng quên rằng, file robots.txt chỉ là một phần trong chiến lược SEO tổng thể của bạn. Để đạt được thành công, bạn cần kết hợp nó với các kỹ thuật SEO khác như tối ưu hóa nội dung, xây dựng liên kết và cải thiện trải nghiệm người dùng. Bạn có thể tham khảo thêm về các kỹ năng cần thiết cho tương lai và cách AI hỗ trợ trong bài viết Kỹ năng tương lai bí quyết bứt phá để thành công cùng AI.

Chúc bạn thành công trên con đường chinh phục đỉnh cao SEO!

File robots.txt là một file văn bản hướng dẫn bot tìm kiếm cách thu thập dữ liệu trên website, giúp kiểm soát nội dung nào được index và nội dung nào không.

File robots.txt giúp kiểm soát thu thập dữ liệu, tiết kiệm tài nguyên, bảo vệ nội dung riêng tư và cải thiện thứ hạng SEO bằng cách đảm bảo bot tìm kiếm thu thập dữ liệu hiệu quả.

Công cụ của KiraApp cho phép bạn cấu hình user-agent, chỉ định các đường dẫn được phép (Allow) hoặc không được phép (Disallow), và thêm sitemap để tạo file robots.txt chuẩn SEO.

Bạn có thể thêm quy tắc tùy chỉnh bằng cách chỉ định user-agent và đường dẫn muốn chặn hoặc cho phép, ví dụ: chặn truy cập vào thư mục wp-admin hoặc các trang kết quả tìm kiếm nội bộ.

Sau khi tạo, bạn cần tải file robots.txt lên thư mục gốc của website thông qua trình quản lý file của hosting hoặc phần mềm FTP.

Có, bạn có thể sử dụng file robots.txt để chặn các bot gây hại bằng cách thêm quy tắc Disallow cho user-agent của chúng.

Cần tránh chặn toàn bộ website, sử dụng sai cú pháp, không kiểm tra file robots.txt sau khi chỉnh sửa, và dựa dẫm quá nhiều vào file robots.txt để bảo mật.

Cần kết hợp file robots.txt với các kỹ thuật SEO khác như tối ưu hóa nội dung, xây dựng liên kết và cải thiện trải nghiệm người dùng để đạt được thành công.

Đánh giá từ khách hàng

Tổng hợp trải nghiệm thực tế từ khách đã lưu trú.

Tuyệt vời

12 đánh giá

Cao Thị Thảo

Đã đánh giá vào 01/02/2026

Mình là designer, ít khi quan tâm đến SEO. Nhưng đọc bài viết này thấy robots.txt cũng quan trọng phết. Mình sẽ thử tạo một file robots.txt cho website cá nhân của mình xem sao. Cảm ơn KiraApp!

Trương Công Minh

Đã đánh giá vào 01/02/2026

Bài viết hay và đầy đủ thông tin. Mình đánh giá cao phần 'Những sai lầm cần tránh khi sử dụng file robots.txt', giúp người dùng tránh được những lỗi cơ bản có thể gây ảnh hưởng đến SEO. Mình sẽ chia sẻ bài viết này cho team marketing của mình.

Hoàng Quốc Việt

Đã đánh giá vào 01/02/2026

Mình thấy bài viết này rất cần thiết cho những người mới bắt đầu làm SEO. Robots.txt là một trong những yếu tố quan trọng để tối ưu hóa website cho công cụ tìm kiếm. Cảm ơn KiraApp đã chia sẻ kiến thức!

Vũ Thị Mai

Đã đánh giá vào 01/02/2026

Cảm ơn bài viết của KiraApp, rất bổ ích! Mình muốn hỏi thêm là nếu mình chặn một trang bằng robots.txt rồi, thì trang đó có bị index trên Google nữa không? Hay là mình phải dùng thêm thẻ meta robots nữa?

Đặng Thanh Tùng

Đã đánh giá vào 01/02/2026

Mình thấy phần các trường hợp sử dụng robots.txt nâng cao rất hay. Trước giờ mình chỉ dùng robots.txt để chặn thư mục wp-admin thôi, giờ mới biết có thể dùng để kiểm soát phiên bản ngôn ngữ và xử lý tham số URL nữa. Cảm ơn bạn!

Phạm Hoàng Anh

Đã đánh giá vào 01/02/2026

Bài viết chi tiết quá! Mình đặc biệt thích phần hướng dẫn tạo robots.txt với công cụ của KiraApp, từng bước một rất dễ làm theo. Mình cũng đang quan tâm đến SEO WordPress, để đọc thêm bài viết mà ad gợi ý nữa.

Lê Thu Hương

Đã đánh giá vào 01/02/2026

Mình đang quản lý một website WordPress, trước giờ toàn dùng plugin để tạo robots.txt. Thấy bài viết này giới thiệu công cụ của KiraApp có vẻ hay, lại còn chuẩn SEO nữa. Để mình thử xem có hơn plugin không. Cảm ơn ad nhé!

Nguyễn Văn Nam

Đã đánh giá vào 01/02/2026

Mình là dân kỹ thuật, đọc bài này thấy kiến thức rất cơ bản và dễ hiểu. Công cụ của KiraApp nhìn giao diện trực quan, chắc chắn sẽ giúp ích cho nhiều bạn mới làm quen với SEO. Mình sẽ giới thiệu cho mấy đứa em mới ra trường.

Trần Thị Lan

Đã đánh giá vào 01/02/2026

Bài viết rất hữu ích! Trước giờ mình cứ nghĩ robots.txt là cái gì đó phức tạp lắm, đọc xong bài này mới thấy nó đơn giản hơn mình tưởng. Cảm ơn KiraApp đã chia sẻ công cụ tạo robots.txt, mình sẽ thử ngay cho website bán hàng của mình.

Viết đánh giá của bạn