Robots.txt là một file nhỏ nằm ở gốc website, nhưng lại quyết định Googlebot sẽ đi đâu, bỏ qua đâu khi thu thập dữ liệu. Làm đúng, bạn giúp Google crawl nhanh hơn, tập trung vào trang quan trọng (bài viết, sản phẩm, landing page) và tránh tốn “ngân sách crawl” vào những URL rác như trang tìm kiếm nội bộ, filter, giỏ hàng, trang tài khoản. Làm sai, bạn có thể tự chặn SEO: bài tốt không được crawl, CSS/JS bị khóa khiến Google hiểu sai giao diện, thậm chí cả site “biến mất” khỏi index chỉ vì một dòng Disallow.

Trong bài này, mình sẽ giải thích rõ robots.txt là gì theo cách dễ hiểu, phân biệt crawl vs index để bạn không nhầm “chặn crawl = chặn lên Google”. Bạn cũng sẽ có checklist các phần nên/không nên chặn, mẫu robots.txt dùng được ngay theo từng loại website, và cách kiểm tra lỗi nhanh trên Google Search Console. Nếu bạn muốn làm nhanh hơn mà hạn chế sai sót, mình cũng gợi ý workflow tạo robots.txt và chuẩn hóa URL bằng một vài công cụ miễn phí trên kiraapp.vn.

Robots.txt là gì?

Robots.txt là một file văn bản rất nhỏ, đặt ở “cổng vào” của website. Nó giống như tấm biển hướng dẫn dành cho bot tìm kiếm: đoạn nào được vào xem, đoạn nào nên tránh. Googlebot (và các bot khác) thường đọc file này trước khi bắt đầu thu thập dữ liệu để biết nên crawl những phần nào của site cho hiệu quả.

Robots.txt hoạt động thế nào (crawl vs index)

Để hiểu robots.txt, bạn cần nắm 2 khái niệm: crawl và index.

- Crawl (thu thập dữ liệu): Googlebot “đi” qua các URL, tải nội dung về để đọc.

- Index (lập chỉ mục): Google “lưu” và đưa trang đó vào kho dữ liệu để có thể hiển thị trên kết quả tìm kiếm.

Hãy hình dung đơn giản thế này:

- Crawl = Google đọc sách (mở trang ra, đọc nội dung).

- Index = Google cất sách vào thư viện (ghi vào danh mục để sau này người khác tìm thấy).

Và đây là điểm dễ nhầm nhất: robots.txt tác động chủ yếu lên crawl, không phải index.

- Khi bạn Disallow một đường dẫn trong robots.txt, bạn đang nói với bot: “đừng vào đọc phần này.”

- Nhưng điều đó không tự động có nghĩa trang đó “biến mất khỏi Google”.

Trong một số trường hợp, URL vẫn có thể xuất hiện trên Google nếu:

- URL đó đã từng được index trước đây, hoặc

- URL được website khác trỏ link tới (Google biết URL tồn tại dù không crawl được nội dung)

Vì vậy, nếu mục tiêu của bạn là chặn index chắc chắn, robots.txt không phải “vũ khí chính”. Khi đó thường cần các cách như meta robots noindex, X-Robots-Tag, hoặc yêu cầu đăng nhập/bảo mật (tuỳ tình huống). Robots.txt phù hợp nhất để hướng bot crawl thông minh, tránh lãng phí vào trang không có giá trị SEO (giỏ hàng, trang lọc, tìm kiếm nội bộ, khu vực admin…).

Robots.txt nằm ở đâu và Google đọc khi nào

Robots.txt phải nằm đúng vị trí thì bot mới tìm thấy:

- Đường dẫn chuẩn: https://domain.com/robots.txt

Tức là file đặt ở thư mục gốc (root) của domain. Không phải /assets/robots.txt, không phải /public/robots.txt. Sai đường dẫn là coi như không có.

Về nguyên tắc:

- Mỗi domain/subdomain có 1 robots.txt riêng.

Ví dụ:

- https://example.com/robots.txt áp dụng cho example.com

- https://blog.example.com/robots.txt (nếu có subdomain blog) phải là một file khác

- https://shop.example.com/robots.txt cũng là một file khác

Googlebot thường kiểm tra robots.txt trước khi crawl và có thể kiểm tra lại định kỳ. Vì vậy, mỗi khi bạn sửa robots.txt, hãy coi đó là thao tác “ảnh hưởng lớn”: sửa xong nên test lại để tránh chặn nhầm phần quan trọng của site.

Vì sao website cần robots.txt?

Nhiều người nghĩ robots.txt “có cũng được, không có cũng chẳng sao”. Đúng… nếu website của bạn nhỏ, ít URL, không có filter hay trang hệ thống. Nhưng khi site bắt đầu có nhiều trang (blog lên vài trăm bài, eCommerce có hàng nghìn sản phẩm), robots.txt trở thành một thứ giúp Google hiểu bạn muốn ưu tiên gì và giúp bạn tránh tự tạo ra rác SEO theo thời gian.

Tiết kiệm crawl budget, tăng hiệu quả thu thập dữ liệu

Google không “đi dạo” vô hạn trong website. Bot sẽ dành một mức tài nguyên nhất định để crawl site bạn (tuỳ chất lượng site, tốc độ server, độ uy tín, số lượng URL…). Nếu bạn để bot tốn thời gian vào những trang không quan trọng, thì các trang quan trọng sẽ bị crawl chậm hơn.

Robots.txt giúp bạn “dẫn đường” để bot tập trung vào thứ đáng crawl:

- Danh mục (category/collection) – nơi gom nội dung theo chủ đề

- Bài viết – nội dung chính kéo traffic

- Landing page – trang chuyển đổi

- Trang sản phẩm – trang kiếm tiền trực tiếp

Nói ngắn gọn: bot bớt lãng phí → Google cập nhật nhanh hơn → nội dung mới dễ được thu thập và phản ánh kịp trong tìm kiếm.

Tránh “index rác” từ URL biến thể

Rác SEO thường không đến từ “bài viết dở”. Nó đến từ URL biến thể mà hệ thống tự sinh ra.

Ví dụ rất phổ biến:

- Trang filter/facet (lọc theo giá, màu, size…) tạo ra hàng trăm biến thể URL

- Tham số URL kiểu ?sort=, ?page=, ?filter=, ?utm=…

- Trang sort (sắp xếp theo giá/độ phổ biến)

- Pagination (phân trang) — tuỳ cấu trúc mà có thể tạo nhiều URL mỏng

Khi bot crawl những biến thể này quá nhiều, bạn có thể gặp các vấn đề:

- Google thu thập rất nhiều trang gần giống nhau → tăng nguy cơ duplicate/thin content

- Nội lực crawl bị phân tán → trang “xịn” bị crawl chậm

- Search Console bắt đầu báo “Crawled – currently not indexed” hoặc index những URL bạn không muốn

Robots.txt không phải lúc nào cũng là giải pháp duy nhất, nhưng nó là một công cụ mạnh để giảm lượng URL không đáng crawl, nhất là với eCommerce và site có filter nhiều.

Chặn crawl các khu vực không nên public

Có những khu vực bạn không muốn bot ghé thăm, vì:

- Không có giá trị SEO

- Có thông tin cá nhân

- Hoặc chỉ dành cho người dùng nội bộ

Những mục thường nên cân nhắc chặn crawl:

- Admin / dashboard (khu quản trị)

- Login / register

- Cart / checkout (giỏ hàng, thanh toán)

- Account (tài khoản người dùng)

- Search nội bộ (trang kết quả tìm kiếm trên site)

- Staging / dev (site test trước khi lên production)

Việc này giúp bạn tránh 2 thứ: lãng phí crawl và đưa bot vào vùng “không cần xuất hiện trên Google”.

Lưu ý: robots.txt không phải bảo mật. Nếu là staging/dev hoặc trang nhạy cảm, cách đúng là chặn bằng đăng nhập/mật khẩu, IP allowlist, hoặc noindex.

Giảm rủi ro SEO kỹ thuật

Robots.txt cũng là lớp “dọn đường” để giảm các lỗi kỹ thuật hay gặp:

- Bot crawl những thư mục/file tạo duplicate (ví dụ thư mục test, bản nháp, URL thử nghiệm)

- Crawl nhiều trang nội dung mỏng (kết quả search, trang lọc quá cụ thể, trang tag rác)

- Crawl các trang lỗi hệ thống hoặc URL sinh ra do bug (404 hàng loạt, URL lặp vô hạn)

Khi bạn chặn đúng, bạn đang làm một việc rất thực dụng: giảm nhiễu trong dữ liệu crawl, để Google tập trung hiểu đúng nội dung chính của website.

Khi nào KHÔNG nên dùng robots.txt để chặn index?

Robots.txt rất hữu ích để “hướng bot đi đúng đường”. Nhưng nếu mục tiêu của bạn là chặn index (không cho xuất hiện trên Google), thì robots.txt thường không phải lựa chọn an toàn nhất. Lý do đơn giản: robots.txt chủ yếu nói với bot “đừng crawl”, trong khi index là câu chuyện “Google có đưa URL vào kho và hiển thị hay không”.

3 hiểu lầm phổ biến

1) “Disallow là Google không thấy trang nữa.”

Không hẳn. Disallow chỉ hạn chế việc bot vào đọc nội dung. URL vẫn có thể được Google biết đến từ: backlink, internal link, sitemap cũ, hoặc đã từng được crawl trước đó. Kết quả là đôi khi bạn vẫn thấy URL xuất hiện trên Google, nhưng thông tin hiển thị rất ít (vì Google không được phép đọc nội dung để hiểu sâu).

2) “Robots.txt là bảo mật.”

Không phải. Robots.txt giống “biển hướng dẫn”, không phải “cánh cửa khóa”. File này công khai ở domain.com/robots.txt, ai cũng xem được. Và không phải bot nào cũng tuân thủ. Nếu thứ bạn cần bảo vệ là dữ liệu nhạy cảm, robots.txt không đủ.

3) “Chặn hết rồi mới mở dần cho chắc.”

Đây là kiểu làm dễ “tự bóp SEO” nhất. Chỉ một dòng Disallow: / là bot bị chặn toàn site. Nhiều trường hợp team dev quên mở lại sau khi deploy, khiến website tụt index/crawl, bài mới không được thu thập, traffic giảm mà không hiểu vì sao. Nếu bạn không có quy trình test/kiểm tra sau khi chỉnh robots.txt, cách “chặn hết” rất rủi ro.

Nên dùng gì thay thế trong từng tình huống

1) Cần chặn index chắc chắn → dùng noindex

Nếu bạn muốn trang không xuất hiện trên Google, cách “đúng bài” thường là:

- Meta robots trong HTML: noindex

- Hoặc X-Robots-Tag qua HTTP header (hữu ích cho PDF, file, hoặc rule theo thư mục)

Điểm mạnh: Google có thể crawl để thấy chỉ thị noindex, rồi loại khỏi index rõ ràng hơn so với chỉ Disallow.

2) Cần bảo mật → dùng đăng nhập/mật khẩu/IP allowlist

Với trang staging/dev, dashboard nội bộ, dữ liệu người dùng… hãy khóa bằng:

- Yêu cầu đăng nhập/mật khẩu

- Chặn theo IP (allowlist)

- Hoặc các cơ chế bảo mật khác phía server

Robots.txt chỉ nên là lớp “phụ” trong trường hợp này, không phải lớp chính.

3) Cần xử lý duplicate → dùng canonical/redirect

Khi vấn đề là nhiều URL na ná nhau (filter/sort, phiên bản http/https, www/non-www, slug cũ…), ưu tiên:

- Canonical: chỉ định URL “chuẩn” để Google hiểu trang gốc

- 301 Redirect: gom tín hiệu về một URL duy nhất (khi bạn chắc chắn URL cũ nên biến mất)

Tóm lại: robots.txt là công cụ quản lý crawl, không phải công cụ “xóa khỏi Google”. Dùng đúng việc, bạn sẽ thấy site gọn hơn, bot crawl thông minh hơn. Dùng sai việc, bạn sẽ dễ rơi vào tình trạng “chặn nhầm cái cần lên top”.

Robots.txt nên chặn những gì?

Không có một robots.txt “chuẩn cho mọi site”. Cách đúng là: chặn những phần không có giá trị SEO hoặc gây nhiễu, nhưng không chặn nhầm các trang đang kéo traffic/doanh thu. Dưới đây là checklist theo từng loại website để bạn áp dụng nhanh.

Lưu ý: robots.txt chỉ ưu tiên chặn crawl. Nếu bạn cần chặn index chắc chắn, hãy kết hợp noindex (meta robots / X-Robots-Tag) hoặc bảo mật bằng đăng nhập.

Website blog/doanh nghiệp (checklist gợi ý)

| Mục nên cân nhắc chặn crawl | Vì sao nên chặn | Lưu ý an toàn |

| /wp-admin/ (hoặc khu quản trị tương đương) | Không có giá trị SEO, tránh bot lãng phí | Với WordPress thường vẫn Allow admin-ajax.php nếu cần |

| Trang tìm kiếm nội bộ (ví dụ /search, ?s=…) | Dễ tạo hàng loạt trang mỏng/duplicate | Nhiều guideline SEO khuyên không index search nội bộ |

| “Tag rác” / tag tạo tự động quá nhiều | Tăng trang mỏng, loãng topical authority | Nếu tag là chiến lược nội dung (ít nhưng chất), đừng chặn |

| Trang test, preview, bản nháp public | Không dành cho người dùng, dễ bị index nhầm | Tốt nhất dùng noindex hoặc bảo vệ truy cập |

Gợi ý thực chiến: với blog/doanh nghiệp, ưu tiên chặn search nội bộ + khu admin + trang test. Còn category/landing/bài viết chính thì không chặn.

Website thương mại điện tử (checklist gợi ý)

| Mục nên chặn crawl | Vì sao nên chặn | Lưu ý an toàn |

| /cart (giỏ hàng) | Không có giá trị SEO, chứa trạng thái theo người dùng | Không nên index |

| /checkout (thanh toán) | Trang giao dịch, không phải trang tìm kiếm | Cần ưu tiên bảo mật |

| /account (tài khoản) | Thông tin cá nhân, không có giá trị SEO | Chặn crawl + yêu cầu đăng nhập |

| URL filter/sort tạo biến thể lớn (facet/filter) | Sinh ra hàng nghìn URL gần giống nhau, tốn crawl budget | Cần đánh giá: có filter nào tạo “landing SEO” không |

| Tham số URL dạng ?sort=, ?filter=, ?price=… | Nhiễu, dễ duplicate | Có thể xử lý thêm bằng canonical/param handling tùy hệ thống |

Điểm quan trọng nhất của eCommerce: đừng để bot sa vào “mê cung filter”. Một site sản phẩm nhiều mà filter mở toang thường sẽ thấy Search Console báo crawl nhiều nhưng index ít, hoặc index nhiều URL “lạ”.

Website có staging/dev (quan trọng: tránh index nhầm)

Với staging/dev, mục tiêu không chỉ là “đừng crawl” mà là đừng để lộ và đừng để index. Best practice theo thứ tự ưu tiên:

1) Ưu tiên bảo mật trước (khuyến nghị mạnh)

- Bật đăng nhập/mật khẩu (basic auth)

- Hoặc chặn theo IP allowlist

- Hoặc đặt staging trong môi trường không public

2) Chặn index chắc chắn

- Gắn noindex toàn site (meta robots hoặc X-Robots-Tag)

3) Robots.txt chỉ là lớp phụ

- Có thể thêm Disallow: / để giảm crawl nhưng không được coi là “đã an toàn”

Mẹo tránh tai nạn: staging/dev thường “vô tình” bị index khi team quên bật noindex hoặc quên khóa bằng auth. Nếu bạn từng thấy trên Google xuất hiện URL kiểu staging.domain.com, đó là dấu hiệu workflow deploy đang thiếu bước kiểm tra.

Cấu trúc robots.txt chuẩn

Robots.txt càng gọn – rõ – dễ bảo trì càng tốt. Bạn không cần biến nó thành “bài toán lập trình”. Chỉ cần nắm đúng các dòng cơ bản và vài nguyên tắc an toàn là đủ để tránh chặn nhầm.

Các directive cơ bản

Dưới đây là các chỉ thị (directive) bạn sẽ gặp nhiều nhất:

1) User-agent — áp dụng cho bot nào

Bạn đang nói chuyện với ai: Googlebot, Bingbot, hay tất cả bot?

- User-agent: * nghĩa là áp dụng cho tất cả bot.

- User-agent: Googlebot nghĩa là chỉ áp dụng cho Googlebot.

2) Disallow — không cho crawl đường dẫn nào

Ví dụ: chặn bot vào khu admin

- Disallow: /wp-admin/

3) Allow — cho crawl lại một phần bên trong vùng đang chặn

Hay dùng khi bạn chặn rộng một thư mục nhưng muốn mở một file/đường dẫn con.

Ví dụ (WordPress): chặn admin nhưng vẫn cho crawl file ajax cần thiết:

- Disallow: /wp-admin/

- Allow: /wp-admin/admin-ajax.php

4) Sitemap — chỉ đường cho bot tới sitemap

Dòng này không bắt buộc, nhưng rất nên có vì nó giúp bot tìm sitemap nhanh hơn.

Ví dụ:

- Sitemap: https://example.com/sitemap.xml

Lưu ý: Sitemap có thể đặt ở cuối file và không cần nằm trong block User-agent.

Wildcard * và ký tự $ (1–2 ví dụ dễ hiểu)

Tuỳ bot, robots.txt hỗ trợ pattern (mẫu khớp) để chặn theo kiểu “bắt tất cả”.

- * = khớp với “bất kỳ ký tự nào”

- $ = khớp “kết thúc URL”

Ví dụ thực tế:

Ví dụ 1: Chặn mọi URL có tham số ?s= (search nội bộ kiểu WordPress)

- Disallow: /*?s=

Ví dụ 2: Chặn các URL kết thúc bằng .pdf (nếu bạn không muốn bot crawl PDF)

- Disallow: /*.pdf$

Đừng lạm dụng pattern phức tạp. Càng phức tạp càng dễ chặn nhầm, nhất là với site nhiều rule.

5 nguyên tắc “an toàn” trước khi publish

Đây là checklist mình khuyên bạn phải soi lại trước khi đưa robots.txt lên production. Chỉ cần bỏ sót 1 dòng là có thể “toang” SEO.

1) Không chặn CSS/JS quan trọng

Nếu bot không tải được CSS/JS, Google có thể render sai giao diện và hiểu sai nội dung. Chỉ chặn khi bạn chắc chắn đó là thư mục không liên quan hiển thị.

2) Không chặn toàn site nhầm (Disallow: /)

Đây là lỗi kinh điển. Nhiều team dùng để chặn site trong lúc dev rồi quên mở lại. Nếu bạn thấy trong robots có:

- User-agent: *

- Disallow: /

…thì hiểu đơn giản là: “cấm bot vào toàn bộ website.”

3) Luôn khai báo sitemap (nếu có)

Sitemap giúp bot tìm đường tới các URL quan trọng nhanh hơn, nhất là với site lớn hoặc site mới.

Ví dụ:

- Sitemap: https://example.com/sitemap.xml

4) Test trên staging trước (nhưng staging phải được chặn index đúng cách)

Bạn nên thử rule trên staging để tránh đẩy lỗi lên production. Tuy nhiên, staging cần được bảo vệ đúng: đăng nhập/mật khẩu + noindex (robots.txt chỉ là lớp phụ).

5) Ghi chú (comment) để team dễ bảo trì

Robots.txt cho phép comment bằng ký tự #. Ghi chú giúp bạn và team tránh “quên lý do chặn” sau vài tháng.

Ví dụ:

- # Chặn khu admin để tiết kiệm crawl budget

- Disallow: /wp-admin/

Cách kiểm tra robots.txt đúng chuẩn (tránh lỗi ngớ ngẩn)

Robots.txt sai thường không “nổ” ngay. Nó âm thầm làm Google crawl lệch hướng, rồi vài ngày/tuần sau bạn mới thấy traffic tụt hoặc bài mới không lên index. Vì vậy, trước và sau khi chỉnh robots.txt, hãy kiểm tra theo 3 lớp: (1) file có truy cập được không, (2) Google hiểu rule đúng không, (3) có dấu hiệu tự chặn SEO không.

Kiểm tra nhanh bằng trình duyệt

Cách đơn giản nhất là mở trực tiếp:

- https://domain.com/robots.txt

Bạn cần nhìn 2 thứ:

- File có hiện nội dung không

Nếu trình duyệt mở ra được nội dung robots.txt, đó là bước đầu ổn. - Có trả đúng mã phản hồi không (200 OK)

- 200 OK: file tồn tại và truy cập được (tốt)

- 404 Not Found: website đang không có robots.txt (không phải “lỗi chết người”, nhưng bạn mất quyền chủ động điều hướng bot)

- 403 Forbidden: bot có thể bị chặn không đọc được robots.txt → dễ phát sinh vấn đề crawl

- 5xx: lỗi server → Google có thể tạm dừng/giảm crawl

Mẹo nhỏ: nếu bạn vừa deploy robots.txt mà mở không thấy thay đổi, có thể do cache/CDN. Hãy thử mở bằng tab ẩn danh hoặc thêm ?v=1 để kiểm tra nhanh.

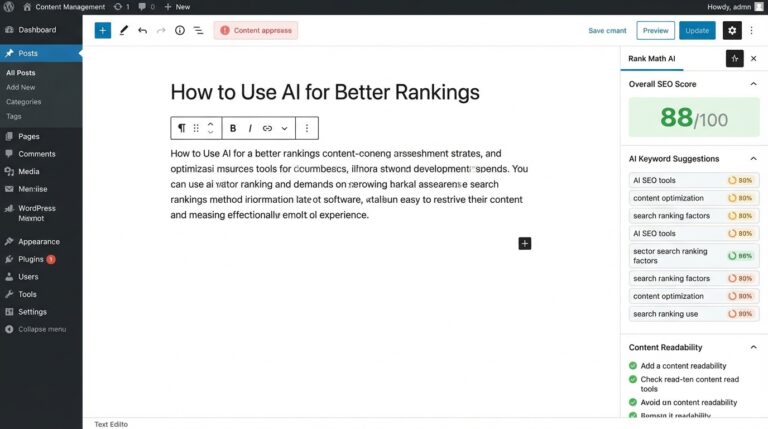

Kiểm tra bằng Google Search Console

Nếu muốn chắc chắn “Google đọc và hiểu robots.txt theo cách bạn muốn”, Google Search Console là nơi nên kiểm tra.

1) Robots.txt Tester (kiểm tra rule)

Bạn dùng công cụ này để:

- Xem Google đang nhận phiên bản robots.txt nào

- Nhập thử một URL cụ thể và kiểm tra Allowed/Blocked

- Phát hiện lỗi cú pháp hoặc rule chồng chéo

Gợi ý thao tác (nhanh, không rườm rà):

- Mở Search Console → chọn property đúng domain

- Vào phần công cụ robots.txt (Robots.txt Tester)

- Dán một vài URL quan trọng để test (bài viết, danh mục, sản phẩm)

- Dán thêm các URL bạn định chặn (cart/checkout/search/filter) để xác nhận đang bị block đúng

2) URL Inspection (kiểm tra từng trang quan trọng)

Dùng khi bạn nghi ngờ “trang này không được crawl/index vì robots.txt”:

- Dán URL → xem trạng thái Indexing

- Nếu bị chặn, GSC thường báo rõ lý do kiểu “Blocked by robots.txt”

- Với trang quan trọng, bạn có thể kiểm tra thêm lần crawl gần nhất và tình trạng render (đặc biệt hữu ích khi nghi CSS/JS bị chặn)

Dấu hiệu bạn đang “tự chặn” SEO

Nếu thấy một trong các dấu hiệu sau, khả năng cao robots.txt đang chặn nhầm hoặc chặn quá tay:

1) Trang quan trọng không được crawl/index

- Bài mới đăng lâu mà không thấy lên Google

- Trang danh mục/sản phẩm chủ lực rớt index hoặc không cập nhật thay đổi

2) Coverage/Indexing báo “Blocked by robots.txt”

Trong Search Console, các báo cáo Indexing/Coverage xuất hiện thông báo:

- Blocked by robots.txt

- hoặc các URL quan trọng bị liệt kê trong nhóm bị chặn

Đây là dấu hiệu “đỏ chót”, vì nó cho thấy Google đang muốn crawl nhưng bị bạn chặn cửa.

3) Bot không tải được CSS/JS

Trường hợp này nguy hiểm vì Google có thể render sai → hiểu sai layout/nội dung → ảnh hưởng khả năng đánh giá trang.

Dấu hiệu thường gặp:

- GSC báo tài nguyên bị chặn

- Khi “Test live URL” thấy render thiếu style hoặc thiếu thành phần quan trọng

Checklist siêu nhanh để bạn tự test:

- Test 5 URL quan trọng nhất (money pages) → phải Allowed

- Test các URL “không nên crawl” (cart/checkout/search/filter) → Blocked

- Đảm bảo không chặn thư mục chứa CSS/JS quan trọng

Lỗi robots.txt phổ biến và cách sửa

Robots.txt “nguy hiểm” ở chỗ: sai một dòng là bot đi lệch đường, nhưng bạn thường chỉ thấy hậu quả sau vài ngày hoặc vài tuần. Dưới đây là các lỗi phổ biến nhất (và cách sửa theo hướng an toàn, đúng bản chất crawl vs index).

Chặn / toàn site (lỗi kinh điển)

Triệu chứng

- Bài mới không lên Google

- Nhiều URL trong Search Console báo “Blocked by robots.txt”

- Traffic organic giảm rõ rệt sau khi deploy/chỉnh sửa

Nguyên nhân

Bạn (hoặc dev) để rule kiểu này:

- User-agent: *

- Disallow: /

Nó có nghĩa: cấm bot crawl toàn bộ website.

Cách sửa

- Xoá hoặc thay bằng rule chặn đúng khu vực cần chặn.

- Nếu trước đó dùng để chặn staging/dev, đảm bảo không “copy nhầm” sang production.

Mẹo an toàn: trước khi publish, luôn search trong file robots.txt xem có Disallow: / không. Thấy là phải dừng lại kiểm tra ngay.

Chặn nhầm thư mục chứa CSS/JS hoặc ảnh quan trọng

Triệu chứng

- Google render trang sai (mất layout, thiếu thành phần)

- Search Console báo tài nguyên bị chặn

- Trang vẫn được index nhưng hiệu suất/hiển thị giảm, đôi khi tụt hạng vì Google “hiểu sai”

Nguyên nhân

Bạn vô tình chặn các thư mục tài nguyên như:

- /assets/, /static/, /wp-includes/ (tuỳ hệ thống)

- hoặc chặn theo pattern quá rộng

Cách sửa

- Bỏ chặn thư mục tài nguyên quan trọng, hoặc Allow lại file/thư mục con cần thiết.

- Nguyên tắc: đừng chặn cái giúp Google render nội dung.

Ví dụ logic “chặn rộng nhưng mở một phần cần thiết”:

- Chặn một thư mục lớn

- Rồi Allow lại đúng đường dẫn file quan trọng (chỉ dùng khi bạn chắc chắn)

Chặn nhầm trang cần index (category / product / blog post)

Triệu chứng

- Danh mục/sản phẩm chủ lực biến mất khỏi Google

- URL Inspection báo bị chặn bởi robots.txt

- Nội dung quan trọng không được crawl cập nhật

Nguyên nhân

Rule chặn quá tay, ví dụ:

- Chặn cả /blog/ vì tưởng là trang hệ thống

- Chặn /category/ vì nghĩ category “không quan trọng”

- Chặn /product/ do nhầm với trang filter/sort

Cách sửa

- Rà lại danh sách “money pages”: danh mục, bài viết, sản phẩm, landing page.

- Đảm bảo các URL đó Allowed trong robots.txt.

- Nếu mục tiêu là giảm URL biến thể (filter/sort), hãy chặn đúng pattern của filter/sort chứ không chặn cả thư mục sản phẩm.

Nguyên tắc: chặn URL rác theo dấu hiệu rác (tham số lọc, sort, search nội bộ), không chặn theo cảm tính.

Dùng rule quá phức tạp, chồng chéo

Triệu chứng

- Test URL lúc thì bị chặn, lúc thì không

- Team không ai dám chỉnh vì “sợ vỡ”

- Xuất hiện nhiều block User-agent khác nhau gây mâu thuẫn

Nguyên nhân

- Quá nhiều pattern *, quá nhiều dòng Allow/Disallow đè lên nhau

- Có nhiều block cho nhiều bot nhưng không có lý do rõ ràng

- Copy/paste từ nhiều nguồn khác nhau

Cách sửa

- Đưa robots.txt về nguyên tắc: ít dòng nhưng đúng mục tiêu.

- Gom rule theo nhóm: (1) chặn khu vực hệ thống (2) chặn search/filter (3) khai báo sitemap.

- Thêm comment để ai đọc cũng hiểu “vì sao chặn”.

Robots.txt tốt thường nhìn vào là hiểu ngay. Nếu nhìn mà rối, khả năng cao bạn đang chặn nhầm ở đâu đó.

Quên cập nhật sitemap khi đổi cấu trúc URL

Triệu chứng

- Google crawl chậm các URL mới

- Indexing cập nhật chậm sau khi đổi slug/cấu trúc

- Sitemap báo lỗi/URL cũ vẫn tồn tại

Nguyên nhân

- Bạn đổi đường dẫn sitemap (hoặc dùng sitemap index mới) nhưng robots.txt vẫn trỏ về sitemap cũ

- Website chuyển plugin SEO / đổi CMS khiến sitemap path thay đổi

Cách sửa

- Mở sitemap hiện tại để xác nhận URL đúng, rồi cập nhật dòng:

- Sitemap: https://domain.com/sitemap.xml (hoặc sitemap index)

- Sau đó vào Search Console gửi lại sitemap và kiểm tra trạng thái đọc sitemap.

Workflow nhanh bằng tool

Làm robots.txt đúng không khó. Khó ở chỗ… dễ sai vì vội, và sai thì ảnh hưởng lớn. Nếu bạn muốn “làm đúng nhanh hơn” (nhất là khi cần chuẩn hóa nhiều thứ trong một lần triển khai), bạn có thể áp dụng workflow gọn sau.

Tạo robots.txt đúng chuẩn trong 1–2 phút

Thay vì ngồi gõ từ đầu rồi lo sai cú pháp, bạn có thể dùng tool Tạo file robots.txt trên kiraapp.vn theo kiểu “template trước – chỉnh sau”:

- Chọn mẫu gần giống website của bạn (blog/doanh nghiệp hoặc eCommerce)

- Tick/chọn các phần cần chặn (admin, cart/checkout, search nội bộ, filter/sort…)

- Rà lại rule cho các trang quan trọng (category, bài viết, sản phẩm) để đảm bảo không bị chặn nhầm

- Xuất file robots.txt và đưa lên đúng đường dẫn domain.com/robots.txt

Cái lợi ở đây là bạn có “khung chuẩn” sẵn, giảm lỗi ngớ ngẩn như thiếu User-agent, đặt sai dấu /, hoặc quên dòng Sitemap.

Khi cần xử lý redirect/canonical kỹ thuật

Robots.txt giúp quản lý crawl, nhưng nhiều vấn đề SEO kỹ thuật lại cần xử lý ở tầng server, ví dụ:

- chuyển http → https

- gom www → non-www (hoặc ngược lại)

- redirect slug cũ sang slug mới

- loại bỏ đuôi URL không cần thiết, chuẩn hóa đường dẫn

Với website chạy Apache, bạn có thể tham khảo các mẫu cấu hình trong tool File .htaccess trên kiraapp.vn để làm nhanh phần redirect chuẩn.

Lưu ý: redirect/canonical là phần “nhạy”, làm sai có thể tạo vòng lặp hoặc mất index. Nếu bạn không chắc, hãy test trên staging và kiểm tra lại bằng URL Inspection trong Search Console.

Chuẩn hoá URL để giảm biến thể & dễ crawl

Một nguồn “rác URL” rất hay gặp là slug có dấu/ký tự lạ, đặc biệt khi copy từ tiêu đề tiếng Việt hoặc từ tài liệu/Word. Slug không sạch dễ dẫn đến:

- URL dài, khó chia sẻ

- lỗi encode, tạo nhiều phiên bản URL

- khó nhất quán khi scale nội dung

Giải pháp nhanh: dùng tool Tạo slug tiếng Việt trên kiraapp.vn để tạo slug:

- không dấu

- ngắn – rõ – đúng intent

- hạn chế ký tự lỗi

Bạn sẽ thấy hiệu quả ngay khi làm SEO lâu dài: cấu trúc URL “gọn” hơn, bot crawl dễ hơn, và team cũng dễ quản trị hơn.

Bonus technical SEO liên quan tới schema & tốc độ (section ngắn)

1) Schema JSON-LD: dễ đọc, dễ debug hơn

Nếu bạn đang dùng Schema để hỗ trợ rich results (Article, Product, Breadcrumb…), thì JSON-LD là thứ bạn sẽ chỉnh sửa khá thường xuyên. JSON “xấu” rất khó soi lỗi (thiếu dấu phẩy, sai ngoặc).

- Dùng Nén & Làm đẹp JSON trên kiraapp.vn để format schema gọn gàng, dễ đọc.

- Dùng So sánh JSON để đối chiếu 2 phiên bản schema trước/sau khi chỉnh (rất tiện khi bạn đang fix lỗi hoặc update thuộc tính).

2) Tối ưu dung lượng khi cần (nhắc ngắn, không lan man)

Nếu bạn đang tối ưu hiệu năng ở mức cơ bản (đặc biệt với landing page), tool Nén & Làm đẹp HTML/CSS/JavaScript có thể giúp giảm dung lượng và gọn code. Dĩ nhiên, tối ưu tốc độ tốt nhất còn phụ thuộc cache/CDN và cách build, nhưng bước “làm gọn” này giúp bạn kiểm tra nhanh và dọn code bớt rối.

Tóm lại: robots.txt là một phần của technical SEO, và technical SEO thường “tốn thời gian vì tiểu tiết”. Workflow trên giúp bạn giảm sai sót và triển khai nhanh hơn, nhưng vẫn đúng bản chất: ưu tiên trang quan trọng, giảm URL rác, và kiểm tra lại trước khi publish.

Xem thêm: Metadata là gì? Hiểu đúng để tối ưu SEO, tránh lỗi index và không “lộ info” trong ảnh/PDF

Robots.txt không phải “mẹo lên top”, nhưng lại là thứ giúp website đi đúng đường trong mắt Google. Khi bạn hiểu rõ crawl khác index, bạn sẽ biết chặn cái gì để tiết kiệm crawl budget, tránh index rác từ URL biến thể, và hạn chế những lỗi kỹ thuật kiểu “tự chặn” mà rất nhiều website dính phải. Chỉ cần làm đúng vài nguyên tắc: không chặn CSS/JS quan trọng, không Disallow toàn site, khai báo sitemap, và test lại trên Search Console—là bạn đã tránh được phần lớn rủi ro.

Nếu bạn muốn triển khai nhanh mà vẫn chắc tay, hãy biến việc này thành một workflow: tạo robots.txt theo template, chuẩn hoá URL ngay từ đầu, rồi kiểm tra lại trước khi publish. Bạn có thể tham khảo các công cụ liên quan trên kiraapp.vn như Tạo file robots.txt, Tạo slug tiếng Việt, File .htaccess, Nén & Làm đẹp JSON / So sánh JSON (hữu ích khi chỉnh Schema), để rút ngắn thời gian và giảm lỗi vặt. Làm technical SEO “đúng và gọn” sẽ giúp Google hiểu site bạn nhanh hơn—và về lâu dài, đó là nền tảng để nội dung tốt có cơ hội được nhìn thấy nhiều hơn.

Câu hỏi thường gặp về Robots.txt

Không có robots.txt thì website có sao không?

Không có robots.txt thì Googlebot vẫn có thể crawl website bình thường. Nhưng bạn sẽ thiếu “bảng chỉ đường” để chặn những khu vực không cần crawl (search nội bộ, filter, cart/checkout…), nên dễ lãng phí crawl budget và phát sinh URL rác theo thời gian. Với site nhỏ có ít URL thì ảnh hưởng thường không lớn, còn site lớn/eCommerce thì nên có.

Disallow có làm URL biến mất khỏi Google không?

Không chắc. Disallow chủ yếu chặn crawl, không phải “xóa khỏi Google”. URL vẫn có thể xuất hiện nếu đã từng được index hoặc được website khác trỏ link tới. Muốn chặn index chắc chắn hơn, hãy dùng noindex (meta robots hoặc X-Robots-Tag) hoặc yêu cầu đăng nhập/bảo mật.

Robots.txt có nên chặn /wp-admin/ không?

Thường là nên, vì khu quản trị không có giá trị SEO và không cần bot crawl. Với WordPress, nhiều site vẫn Allow admin-ajax.php để tránh ảnh hưởng một số chức năng. Nếu site bạn không dùng WordPress, nguyên tắc vẫn giống nhau: chặn khu admin/dashboard để giảm nhiễu.

Có nên khai báo sitemap trong robots.txt không?

Nên, nếu bạn có sitemap. Dòng Sitemap: https://domain.com/sitemap.xml giúp bot tìm sitemap nhanh hơn và ưu tiên crawl các URL quan trọng. Đây là bước đơn giản, ít rủi ro và có lợi cho technical SEO.

Chặn filter/sort bằng robots.txt có ảnh hưởng chuyển đổi không?

Thường không ảnh hưởng chuyển đổi trực tiếp, vì người dùng vẫn truy cập filter/sort bình thường—robots.txt chỉ hướng dẫn bot. Nhưng nếu bạn đang dùng filter như “landing SEO” (ví dụ trang lọc theo nhu cầu có traffic tự nhiên), chặn bừa có thể làm mất cơ hội organic. Cách tốt nhất là chặn những biến thể tạo rác, còn trang lọc có giá trị thì thiết kế/định danh rõ để tối ưu riêng.

Robots.txt có giúp tăng thứ hạng không hay chỉ hỗ trợ crawl?

Robots.txt không phải yếu tố xếp hạng trực tiếp. Tác dụng chính là hỗ trợ Google crawl hiệu quả hơn, giảm URL rác và tránh tự chặn tài nguyên quan trọng (CSS/JS). Khi crawl “sạch” và tập trung, nội dung quan trọng được thu thập nhanh và ổn định hơn—từ đó hỗ trợ SEO gián tiếp.

Website staging bị index rồi thì xử lý thế nào nhanh nhất?

Ưu tiên 1 là bảo mật: bật đăng nhập/mật khẩu hoặc chặn IP để Google không truy cập được. Ưu tiên 2 là gắn noindex toàn site (meta robots hoặc X-Robots-Tag), sau đó dùng Search Console kiểm tra và yêu cầu xử lý. Robots.txt chỉ nên là lớp phụ; đừng dựa vào Disallow: / như giải pháp “chắc chắn”.

Đánh giá từ khách hàng

Tổng hợp trải nghiệm thực tế từ khách đã lưu trú.

Tuyệt vời

5 đánh giá

Đặng Thu Thảo

Đã đánh giá vào 23/01/2026

Nội dung chất lượng, cách trình bày các checklist cho từng loại web (blog, ecommerce) giúp người mới như mình dễ áp dụng ngay. Mình cũng vừa dùng thử cái tool tạo slug tiếng Việt mà bài viết gợi ý, URL ra nhìn sạch và chuyên nghiệp hơn hẳn.

Nguyễn Văn Bình

Đã đánh giá vào 23/01/2026

Thông tin rất đầy đủ, từ cách đặt file ở thư mục gốc đến việc dùng ký tự wildcard. Đặc biệt là lưu ý không chặn CSS/JS để Google render đúng layout, một chi tiết nhỏ nhưng rất nhiều người hay bỏ qua.

Trần Quốc Tuấn

Đã đánh giá vào 23/01/2026

Hay nhất là đoạn nói về eCommerce và mấy cái URL filter rác. Website mình bị lỗi 'Crawled - currently not indexed' suốt, giờ mới biết là do bot bị lạc trong đống lọc giá với màu sắc làm tốn crawl budget. Đã dùng thử tool tạo file trên kiraapp.vn, thấy giao diện trực quan, khá tiện cho mấy bạn không rành code mà muốn chuẩn hóa file robots.

Lê Thị Minh Anh

Đã đánh giá vào 23/01/2026

Vừa đọc xong đoạn 'Chặn toàn site' mà giật mình, đúng là lỗi kinh điển của mấy ông dev khi chuyển từ staging sang prod. Anh em làm SEO nên lưu bài này lại để gửi cho đội kỹ thuật mỗi lần deploy site mới cho chắc.

Phan Hoàng Nam

Đã đánh giá vào 23/01/2026

Bài viết phân tích rất kỹ về sự hiểu lầm giữa crawl và index. Trước giờ mình cứ tưởng Disallow trong robots.txt là Google sẽ không cho trang đó lên kết quả tìm kiếm nữa, hèn gì chặn mãi vẫn thấy nó hiện. Cảm ơn tác giả đã giải thích cái ví dụ 'đọc sách' vs 'cất sách vào thư viện' rất trực quan, dễ hình dung hẳn ra!

Viết đánh giá của bạn